Die Augen der Zukunft: vorausschauende Sicherheit im Straßenverkehr

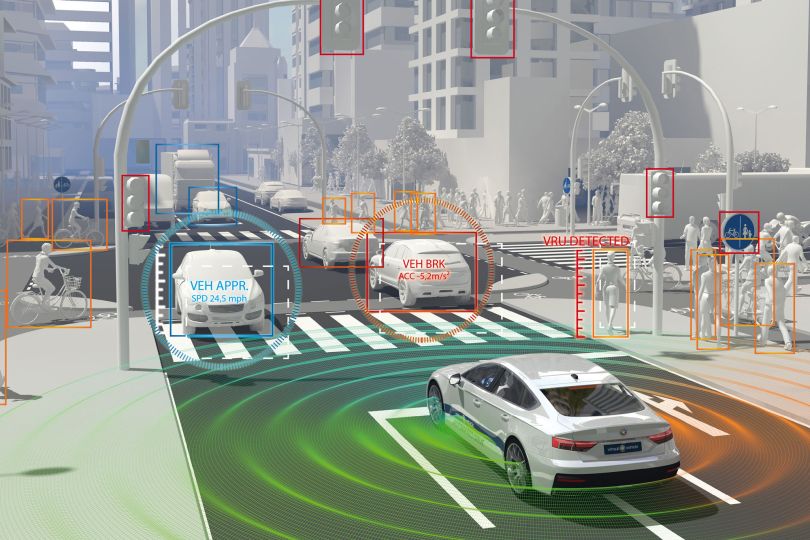

Ein Kind springt plötzlich auf die Straße, ein Fahrradfahrer taucht aus dem nichts auf, ein Fußgänger dreht plötzlich am Zebrastreifen nochmal um – die unvorhersehbaren Szenarien im Straßenverkehr sind vielfältig. Umso wichtiger ist es, selbstfahrende Fahrzeuge mit der Technologie auszustatten, solche Szenarien in Echtzeit zu erfassen und richtig zu beurteilen – idealerweise noch schneller als es ein Mensch je könnte.

Weiterentwicklung der 360° Wahrnehmung von Fahrzeugen

Fahrzeuge sind durch sogenannte LiDAR-Sensoren bereits jetzt in der Lage, ihre Umgebung rund um sich zu erkennen (360° Wahrnehmung).

Unvorhersehbare Szenarien im Straßenverkehr verlangen nach einer Weiterentwicklung der bestehenden Technologie, vor allem im städtischen Bereich. Die dazu nötige signifikante Verbesserung von Gesichtsfeld und Auflösung erfordert Innovationen aller Komponenten eines LiDAR-Sensors: eine hybride Laserquelle für kürzere und intensivere Pulse bei höherer Wiederholrate, ein neues Spiegel- und Package-Design mit größerer Fläche bei größeren Auslenkwinkeln, ein Empfänger mit größerem Detektorfeld und eine effizientere und gleichzeitig genauere Pulsdetektion und Zeitmessung.

3D-Objektdetektion und KI-gestützte LiDAR-Daten

Die resultierenden Punktwolken gehen in die 3D-Objektdetektion und –klassifikation ein. Die Objekte werden in einem sicheren, subsidiären Datenauswerteprozess segmentiert, mit Hilfe von Deep Learning-Algorithmen identifiziert und in Fahrzeuge, Fußgänger, Radfahrer, stationäre Objekte usw. klassifiziert. Diese LiDAR-Daten werden in Folge mittels Sensor Fusion mit Radar- und Kameradaten kombiniert.

Die Hardware für Datenauswertung und Sensor Fusion beinhaltet einen Rechner mit standardisierten Sensorschnittstellen für LiDAR, Radar und Ultraschallsensoren sowie Kameras und die Netzwerkkonnektivität. Dies erlaubt eine umfassende Datensammlung aller Sensoren während Testfahrten.

Die Daten werden annotiert und für Training, Test und Evaluation der Objektklassifikatoren und Algorithmen verwendet. Es ist geplant, resultierende Datensätze öffentlich zur Verfügung zu stellen, um weitere Forschung zu unterstützen; ein Data Management Plan beschreibt die Details für den Zugriff. Des Weiteren soll die Sensorfusions-Hardware als Entwicklungsplattform für zukünftige Forschungsprojekte nutzbar sein. Das Open Simulation Interface soll genutzt werden, um die fusionierten Objekte, Freiflächeninformation usw. den Algorithmen zum Szenenverständnis weiterzureichen, wo die Objekte verfolgt und ihr Verhalten im Sinn einer prädiktiven Gefahrenbewertung vorausgesagt werden.

Use Cases und Ergebnisse

Für die hochrelevante Simulation und Validierung von Fahrerassistenz- und autonomen Systemen im urbanen Umfeld wurden neue Test- und Referenzsysteme auf Basis des hochauflösenden LiDAR-Sensors entwickelt.

Schließlich wurden verschiedene ausgewählte Use Cases, u.a. für Straßen- und Schienenfahrzeuge im städtischen Bereich sowie landwirtschaftliche Anwendungen, umgesetzt, um die Relevanz und Leistungsfähigkeit des Ansatzes praktisch zu demonstrieren.

Fazit

Vulnerable Road Users sind Verkehrsteilnehmer, die besonderen Schutz brauchen. Hinzu kommt, dass diese sogenannten VRUs sich oft nicht vorhersehbar verhalten. Zu diesem Zweck benötigt es intelligenter Sensortechnologie, die seine Umgebung in Echtzeit wahrnimmt, potenzielle Gefahren erkennt und so automatisiertes Fahren im Stadtverkehr ermöglicht. Das Projekt iLIDS4SAM des COMET-Zentrums Virtual Vehicle leistet hierzu einen wichtigen Beitrag.